Минусинск ломает Matrixnet

Disclaimer(отмазка): cлегка ощущаю себя городским сумасшедшим — в очередной раз указываю инженерам Яндекса на ошибки в алгоритмах. Но, честное слово, seo-аудит с указанием на НПС-мерцание — не моих рук дело 🙂 Тем не менее, возьмусь утверждать, что алгоритм Минусинск входит в полное противоречие с основным алгоритмом ранжирования Яндекса — Matrixnet.

В чём суть MatrixNet?

Я уже пытался занудно рассказывать о том, что из себя представляет Матрикснет, теперь попробую разъяснить попроще. На пальцах.

Для обучения алгоритма инженеры Яндекса раздают асессорам, допустим, мешок яблок разных сортов. И просят их оценить вкус этих яблок по 5-бальной шкале. Асессоры коллегиально приходят к решению, что яблоки сорта Ред Делишес вкуснее сорта Голден Делишес и тем более Семеренко или упаси бог Антоновки.

Почему одни яблоки должны быть априори лучше других во всех случаях жизни науке не известно, но с момента вынесения вердикта асессорами MatrixNet считает, что красные сладкие яблоки лучше менее сладких, но жёлтых и уж тем более зелёных и кислых.

То, что мне утром в больницу другу нужны одни яблоки, вечером для шарлотки другие, а завтра себе поесть третьи — инженеры Яндекса особо не задумываются. Более того, они с юношеским задором пытаются на асессорских оценках яблок отсортировать заодно киви или лимоны… Но это я немного отвлёкся на врождённые пороки Матрикснет.

Для продолжения разговора важно лишь то, что после учёта мнения профанов асессоров Матрикснет пытается отсортировать яблоки в соответствии с этим мнением, т.е. так, чтобы Ред Делишес оказался как можно ближе к началу:

А что делает алгоритм Минусинск?

В результате применения алгоритма Минусинск сайт, на который оптимизаторы не очень удачно приобретали SEO ссылки, теряет в выдаче позиции абсолютно по всем запросам. В том числе и по навигационным. То есть по тем запросам, по которым на первом месте должен находится этот сайт и никакой другой.

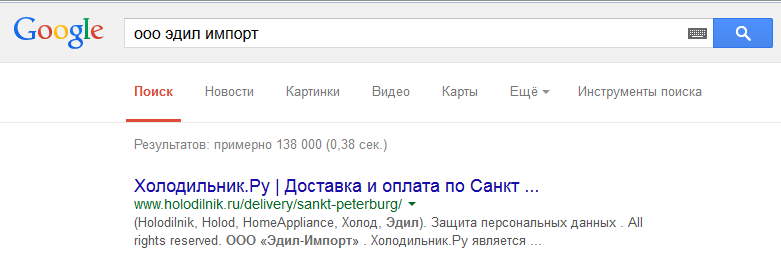

Например, купил я в неком Фирменном центре Бош и Сименс бытовую технику. И возникли у меня некоторые сомнения в качестве одного из приобретённых предметов. Если я поищу в Google название указанное в накладной — ООО «Эдил Импорт», то найду искомое на первом месте:

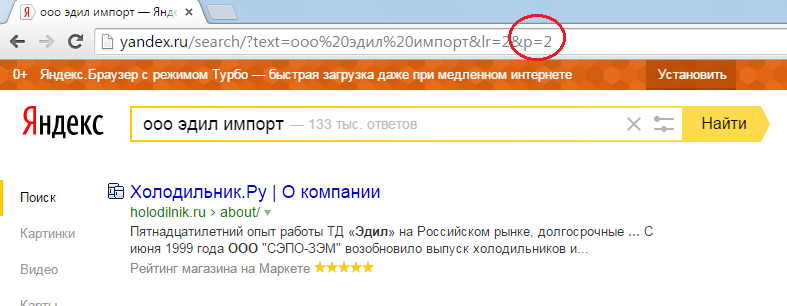

А вот если я поищу его в Яндексе, то тоже найду нужный мне сайт на первом месте. Только не на первой, а на третьей странице выдачи:

Таким образом можно сделать два вывода:

1. Инженерам Яндекса стало наплевать на pFound

2. Минусинск работает как постфильтр, который отрабатывает после MatrixNet. И при этом можно допустить, что сайты для наказания отобраны вручную.

Корень зла не в SEO-ссылках, а в коммерческих факторах ранжирования

Я не зря писал в начале этой заметки об ошибочности попытки ранжирования лимонов после обучения алгоритма МатриксНет на яблоках. Если совершить звонок по горячей линии Бош в России, то сюрприз-сюрприз, выяснится, что магазин, в котором я купил бытовую технику ни разу не фирменный и Бош к нему никакого отношения не имеет.

По злой иронии судьбы я не хотел покупать нужную мне технику в Холодильник.ру, а купил в ООО Эдил-Импорт. То есть там же, но в каком-то не очень афишируемом магазине. Не разобрался в коммерческих факторах, да. Но может быть алгоритмы Яндекса умнее меня?

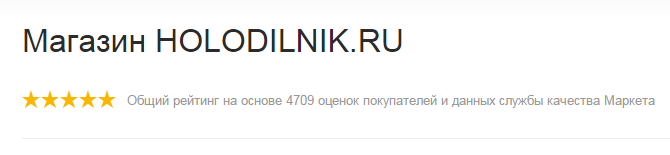

Давай посмотрим на скриншот из Яндекса. Там в снипете красуются гордые 5 звёзд от Маркета. Вот он:

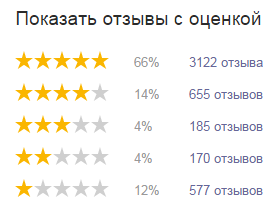

Как же так, магазин торгует как-то полуподпольно, а у него 5 звёзд от Маркета? Давай посмотрим на рейтинг более детально:

Если ты не забыл школьный курс математики, то легко посчитаешь, что каждый шестой оставивший отзыв на маркете поставил сайту Холодильник.ру 2 или вовсе 1 звезду. То есть это не только я — лох, штаны в горох, а каждый шестой был недоволен ООО Эдил-Импорт» чуть более, чем полностью. Каждый шестой, Карл! А служба качества Маркета даёт Холодильнику.ру 5 звёзд, игнорируя мнения пользователей.

Как думаешь, пришлось бы инженерам Яндекса изобретать Минусинск для наказания Холодильник.ру, если бы они умели адекватно считать рейтинг магазина по оценкам пользователей?

P.S: рекомендую прочитать заметку про другой злобный забавный косяк машинного обучения Внезапный диван леопардовой расцветки

Магадан? Находка?? Жмеринка!!!

Для того (ну или до того, как), чтобы начать писать данное сообщение по привычке пользуюсь собственным баром — мне нужен блог Яндекса. Не поиск Яндекса по блогам, а блог компании. Этот или этот. Почему-то я нисколько не удивляюсь, что не нахожу их ни в текущей выдаче, ни в бете, не только в первой десятке, но и в 30-ке тоже. Наверное потому, что сообщение изначально негативно по отношению к качеству поиска Яндекса. (Кстати, ещё одно док-во, что с трастом у Яндекса плохо)

Итак, пока Яндекс хоронит Рамблер (хотя не факт, что Рамблер поменяет именно обычный поиск на гуглёвый), я похоронил поиск Яндекса по гораздо более прозаичной причине — не ищет, собака! (Если бы я был Рабинером, то заголовок данного поста был бы «Как убивали Яндекс» или «Яндекс, который мы потеряли» :D)

Вот несколько ключевых моментов изменений в Яндексе за последние полгода:

- Повернули тумблер релевантности в сторону контента

Разумеется, чтобы не повылазили доры, пришлось ужесточать критерии спамности:На Вашем сайте были проиндексированы страницы, содержащие списки поисковых запросов. В силу того, что по многим запросам Яндекс не может корректно отранжировать такие страницы, мы вынуждены частично исключить Ваш сайт из поисковой базы Яндекса.

Это из переписки с сапортом по поводу выпадения почти всех страниц очень большого белого сайта, на котором были размещены списки, но не ключевых слов, а товаров. Конечно, при очень большом на то желании список из 20 позиций наименований товаров с одним родовым названием (например, лапти плетёные) можно обозвать списком ключевых слов, но три года до этого это спамом не считалось

- Зачем-то поломали зеркальщика

Я никогда не использовал директиву host в файле robots.txt, разумно полагая, что а) нефиг использовать то, что не включено в стандарт и б) 301-й редирект мне поможет. Помогал он мне с 2001-го года, когда я им воспользовался впервые. Во всех поисковиках. Но вот обновлённый зеркальщик Яндекса принял решение выбрать главным тот сайт, с которого идёт 301-й редирект на основной сайт, за что разумеется оба сайта полностью выпали из индекса. Проблему частично решили через сапорт, только зеркало и теперь присутствует в выдаче, без кэша, но находится по ссылкам. По-моему именно по этим причинам в нынешней выдаче очень часто встречаются сайты хостеров (лидер есс-но agava), найденные по ссылкам, к хостингу отношения не имеющим. - Амнистировали дохлые ссылки

В связи с борьбой с платными ссылками, гораздо больший вес получили ссылки, которые в том же Гугле никогда не будут оказывать заметное влияние на выдачу по причине своей никчёмности. Это само по себе не хорошо и не плохо, скажем так — своеобразно. ООО «Продвижение» получило шикарный подарок для своих «Деловых новостей». Сумеют ли они им воспользоваться — покажет время. - Амнистировали внутренние страницы

Стремление, конечно, похвальное, но в совокупности с п.п.1 и 3 выдачу заполонили страницы сомнительного качества с динамическими URL неимоверной длины. Яндексу конечно качество виднее, но я как-то стал задумываться, а не податься ли мне в дорвейщики? 🙂 - Развалили морфологию

Есть такое наблюдение, что в периоды безвременья, Яндекс забывает про свою хвалёную морфологию. Появляется заметная невооруженным взглядом разница в выдаче, к примеру, по запросам в единственном и множественном числе. Заодно выбиваются из штатного ритма апдейтов раз в 3 дня. - Изменили аддитивную операцию

Тут проще на пальцах показать, чем объяснять. Эксперементальный сайт продвигается ссылками с анкорами двух типов: лапти и плетение лаптей. В заголовке присутствует словосочетание плетения лаптя.

В доисторическом Яндексе и в нормальных современных поисковиках сайт ранжировался одинаково успешно по обоим запросам. По причине низкой конкурентности запроса — с поправкой на регион (галка в форме Яндекса) находится менее 500 страниц по запросу лапти и менее 200 страниц по запросу плетение лаптей.

В новом Яндексе наблюдается следующая картина: сайт одинаково хорошо находится по запросам !лапти и !лаптя, при этом отсутствует в выдаче по запросу !лаптей, хотя с ограничением по региону он в выдаче присутствует.

А дальше ещё интереснее. Можно сделать предположение, что по запросу !лаптя сайт находится за счёт статических факторов + текста (ссылок со словом в такой форме нет). По запросу «плетение лаптя» он находится ещё лучше. А вот по запросу !плетение !лаптя сайт отсутствует в выдаче! Но опять же замечательные позиции занимает в региональной выдаче. Т.е. и аддитивность в Яндексе теперь весьма своеобразна.

Вывод: покажите мне того, кто понимает как работает Яндекс (а не как попасть в топ) и я первый кину в него тапок.

Магадан есть. Траста — нет.

На данный момент выдача buki.yandex.ru и yandex.ru по тем запросам, что я успел просмотреть совпадают на 100%. Т.е. Магадан наступил. Или полностью отступил. С чем вас и проздравляю.

А вот Траста в Яндексе нет. Точнее он используется только в малом индексе (индексе, собираемом быстроботом). Объясняю почему. Траст появился для борьбы с дорвеями и линконакруткой. Т.е. самая релевантная страница с абы какого ресурса в топ не попадёт, да и абы какие ссылки работать не будут. В результате, в выдачу попадают внутренние страницы авторитетных ресурсов, например, википедии, социалок, газет и т.д. и т.п. Т.е. достаточно трастовости домена и релевантности внутренней страницы. Ссылки с анкорами не нужны. Пару лет назад на трастовом домене я продвигал внутренние страницы по запросам калибра australia flights без единой внешней ссылки на эту страницу.

И в первую очередь проявляется трастовость на новых запросах типа этого. В малом индексе на первой странице была морда лебедева, форума se.ru и ещё несколько страниц с социалок. Сейчас их нет. И нет их потому, что пресловутый траст при объединении большого и малого индексов перестал работать.

Наблюдение по Магадану: одни и те же страницы присутствуют в выдаче по нескольку раз. И вроде бы это не проделки быстробота.

P.S: траста в google.ru то же пока что наблюдать не доводилось.

Update: как обычно, выдача обновляется постепенно и на 3-х sfront’ах Магадана пока нет. Скорее всего они только на 2-х.

Supplemental Results

Всё что вы хотели узнать о соплях, но боялись спросить 😉

Летом 2007-го года Гугль убрал маркер Supplemental Results (Дополнительные Результаты) у страниц из дополнительного индекса. Однако сопли от этого не исчезли. Если поискать редковстречаемое на просторах интернета словосочетание, то можно увидеть вот такое сообщение:

In order to show you the most relevant results, we have omitted some entries very similar to the 32 already displayed.

If you like, you can repeat the search with the omitted results included.

Что в переводе с английского означает:

Чтобы показать наиболее значимые результаты, мы опустили некоторые, очень похожие на 32 уже показанных.

Если вы хотите, можно повторить поиск, включив опущенные результаты.

Что в переводе на русский означает: если ваш сайт не попал в вышеупомянутый список 32 сайов, то он находится в соплях. Вот моё ИМХО об этом феномене:

1. Сопли не есть наказание за дублирование контента

Это значит, что с одной стороны полные информационные дубли замечательно живут общем индексе, а с другой — добавление к странице уникального контента не помогает выйти из дополнительного индекса (соплей)

2. Слабость страницы не устраняется внешними ссылками

Принято считать, что страницы попадают в сопли из-за низкого PageRank. Это не совсем так. В солпи попадают не только не прокачанные страницы, т.е. с нулевым PageRank, но и запросто с PageRank=3, полученным в основном за счёт внешних ссылок.

3. Сопли являются запросозависимыми!

Для меня это оказалось полной неожиданностью. Вражьи буржуи у себя об этом не пишут. А запросто может быть так, что по одному запросу страница в соплях, а по другому в топ10!

Резюмируя, можно сделать такой вывод: в сопли страница попадает из-за других страниц своего сайта!

Поясню на пальцах. Типичная структура многих сайтов (в частности сайтов ShopXML):

главная -> раздел (категория) -> конечная страница (продукта)

Морда — самая раскачанная страница сайта, на страницу категории есть ссылки c каждой страницы сайта + к этому, на странице категории есть слова, характерные для продукта. Если на страницу продукта есть ссылки только со страницы категории, то он будет в соплях по своему названию, причём внешние ссылки не спасут.

У меня на одном из магазинов с выключенным фильтром (параметр в URL &filter=0, чтобы не мучатся каждый раз вручную, я прописал его в настройках сеобара) страница товара давно на первом месте, однако ж это не мешает этой странице быть в соплях. Мне кажется, что это происходит из-за того, что более релевантной запросу на сайте Гугль считает страницу раздела (при поиске страниц сайта без уточняющего запроса site:www.domain.com она идё выше, уточняющий запрос при поиске по сайту отключает фильтр Supplemental Results), а уже эту страницу он не считает достойной выдачи. Т.е. мне нужно было либо продвигать по запросу страницу раздела, либо ставить больше внутренних ссылок на страницу товара. Чем я сейчас и начну заниматься 🙂

Яндекс погрозил Российской газете пальцем

[n2]

И сказал:

с главной страницы сайта издания, учрежденного Правительством Российской Федерации, стоит ссылка на сайт, торгующий дипломами

Попалилась РГ, одним словом, на торговле говноссылками:

По моим прикидкам РГ может потерять как минимум 100 000 полновесных российских рублей ежемесячного дохода только от продажи ссылок с морды. Сколько могут потерять все продавцы ссылок — сложно вообразить. Правда живём мы в стране непуганых вебмастеров и оптимизаторов, потому как Яндекс уже не впервой грозит СМИ пальчиком, да и не Яндексом единым ходит трафик 🙂

Вот Гугль пальчиком в таких случаях не грозит, он просто понижает PR до неприличного значения. И доход провинившийся теряет гарантированно, а все остальные натягивают на ссылки презерватив rel=»nofollow». (Впрочем, СМИ на Западе крайне редко торгуют ссылками, а особенно мордами, и без санкций — как правило анонсируются только честно аффилированные ресурсы. Оттого видимо и TrustRank у Западных СМИ не чета нашим 😉 ) На мой взгляд это более честный по отношению к вебмастерам подход — за низкий PR никто денеХ [лишних] платить не будет.

Кстати, неучитывать покупные ссылки довольно просто (хотя и ресурсоёмко) — достаточно отслеживать историю появления/исчезновения ссылок на странице. Естественные ссылки как правило исчезают только вместе с ресурсом, на который ссылаются, да и то далеко не всегда…

Что-то мне подсказывает, что новые старости или старые новости породят очередные разновидности в ссылкоторговле. У меня уже есть целый ворох идеек. Желающих приобрести нет? 😀

SEO фактики: о robots.txt, внутренних ссылках и двойной выдаче

Аккуратнее с robots.txt

Из серии знал, но всё равно наступил на грабли: если закрыть в robots.txt большую часть сайта, то можно напороться на тотальную переиндексацию, т.е. вылететь из индекса.

Как это было: сайт из-за кривой реализации ЧПУ (нет обработки некорректных параметров) порождал более 400К страниц известных Яндексу, а в индексе было только около 100К страниц. Поскольку консоль давала понять, что есть проблемы с индексацией нормальных страниц, я решил закрыть фантомные URL (не все, а только те разделы, что попали в отчёт Структура сайта консоли, т.е. содержащие более 1% страниц). Результат, который следовало ожидать: 100К->60К->20 страниц в индексе. Есс-но падение траффика по низкочастотникам неприятно.

Сила внутренних страниц

Побочный эффект — стал отчётливо виден вклад (а точнее его отсутствие) внутренних ссылок в ранжирование. Не такой мощный как в Гугле, но всё же несколько больше, чем я считал ранее.

Эффект от двойного листинга

оказался слегка преувеличенным. Есть у меня один любимый запрос, который довольно давно и стабильно занимает в Гугле первую позицию (не во всех датацентрах есс-но, но во многих, особенно ключевых 😉 ), что позволяет хорошо видеть, как изменится траффик от добавления к ссылке второй, т.к. исключается наложение эффекта увеличения позиции. Поскольку я тащил не к морде внутреннюю страницу, а к одной внутренней — вторую, то несколько дней растянулись на полтора месяца (ожидания, а не работы 😉 ) Изменение трафика по этому запросу не превысило естественных колебаний в течение недели. Если проще — то на графике никакого всплеска не видно, т.е. речь в лучшем случае о нескольких процентах, но никак не об удвоении.

Почему у ребят из Stompernet случилось удвоение, а у меня нет? Очень просто. У меня первая позиция, которая и так забирает себе максимум трафика, т.е. по ней кликают почти все. Двойной же листинг для сайта на более низкой позиции наоборот, помогает привлечь к себе внимание тех, кто не удовлетворился выбором первой позиции. Плюс к этому, работы над получением двойного листинга практически гарантируют улучшение позиций всей пары.

В общем, для себя я решил, что эффективнее расходовать внешние ссылки на занятие первой позиции, чем на получением двойного листинга. Если внутренних ссылок для двойного листинга не хватает, то не очень-то и хотелось 🙂

Про апдейты Яндекса

[n2]

Имеем следующий набор утверждений:

- Внутри яндекса под апдейтом понимают выкладку поисковой базы

- Поисковая база выложена во время t1. Последний проиндексированный документ в ней датирован t2. Приблизительная задержка t2-t1 обычно достигает 1 дня +/- несколько часов.

- Откаты на предыдущию базу не происходят — нет технической возможности

Что имеем из наблюдений за запросом навроде такого:

- Дата самого свежего документа не от быстробота до вчерашнего вечера была 29.12.07

- Вчера вечером дата самого свежего документа была 28.12.07

- Сегодня дата самого свежего документа есть 08.01.08

Из чего делаем такие выводы:

- В военное время значение синуса достигает 2, а то и 3. Т.е. «несколько часов» в формуле t2-t1 доходит до нескольких суток, особенно если учесть, что основная масса самых свежих документов датирована 07.01, т.е. реальная дата документов от 08.01 — слегка заполночь.

- Во время выкладки поисковой базы происходят потери. Те самые документы, которые слегка перевалили за дату (т.е. в нынешнем апдейте это документы от 08.01) куда-то продалбываются.

- Дата самых свежих документов является достаточно надёжным индикатором апдейта.

И бонусный вопрос:

является ли основная масса оптимизаторов высоквалифицированными, если по утверждению г-на Орлова 90% из них не замечают выкладки новой версии поисковой программы (релиза)?

О советах Going Natural 2.0

Вы уже наверное знакомы с переводами от ProfitHunter видео-уроков от StomperNet под названием Going Natural 2.0. Если нет — читайте, там есть очень интересные мысли, хотя я абсолютно не понимаю, как можно делать те же выводы на основании использования тулзы имитирующей зрение пьяного подслеповатого циклопа.

Если кто ещё не в курсе, то вся эта затея по признанию самих режисёров — всего лишь реклама для «Stomper University», т.е. неких курсов, где, как я понимаю, будут одновременно замикшированы некие знания по SEO, SMO и Usability. Надо отдать ребятам должное — реклама получилась знатная и они не только на курсы слушателей на несколько лет вперёд наберут, но и заказов однозначно нахватают не мало.

Но, как вы наверное догадываетесь, реклама всегда несколько отличается от действительности. Скажем, благодаря рекламе все в курсе, что не все йогурты одинаково полезны. Но, на самом деле, они не одинаково полезны для здоровых людей. Для больных они одинаково вредны, поскольку насквозь синтетичны. Не верите? Спросите у своего лечащего врача при случае, дай Бог вам здоровья.

Один из уроков Ходьбы по-естественному 2.0 учит нас избегать фильтров дублированного контента. Не смотря на то, что сама тема очень правильная, т.к. Гугль таки наказывает за дубли, предложенный способ выхода из ситуации весьма и весьма скользок. Конкретное предложение — убирать повторяющийся от страницы к странице текст в картинки. Десять раз подумайте, прежде чем это делать, если вы являетесь владельцем магазина, скажем, на движке ShopXML и не заказали тотального рерайтинга текстов. Дело в том, что Гугль прекрасно осведомлён о существовании класса сайтов под общим названием интернет-магазины, и в курсе что описания многих товаров от магазина к магазину изменить не всегда возможно, по той простой причине, что значимый текст описания для многих товаров будет один и тот же. Поэтому если страница товара X магазина A будет отличаться от страницы такого же товара X магазина B исключительно тем самым обрамляющим текстом, который предлагается убирать в картинки, то этого достаточно для того, чтобы оба магазина прекрасно чувствовали себя в серпах (в жизни таких магазинов куда как больше, чем 2 штуки 😉 ).

А вот если убрать обрамляющий текст в картинки, то страницы товара X в магазинах A и B перестанут отличаться друг от друга или станут слишком похожими и одна из них (а то и обе, если допустить существование аналогичных страниц на других магазинах) загремит под фильтр.

Поэтому правильное решение не укорачивать повторяющийся от страницы к страницы текст, а наращивать объёмы уникального. Хотя и роты копирайтеров может не хватить делать уникальные описания для каких-нибудь аккумуляторов для ноутбуков 🙂

Ещё один совет от Энди был посвящён удвоению траффика из Гугля за счёт «двойного листинга». Всё в этом совете замечательно, т.к. действительно две позиции в SERP’е дадут больше трафика, чем одна. За исключением одного маленького но: одна внутренняя страница в выдаче даст заметно больше продаж, чем две страницы в выдаче, первая из которых является мордой сайта. Это банальность — чем больше кликов до целевой страницы, тем ниже конверсия. Поэтому оптимизировать лучше не легкопродвигаемую морду, а внутреннюю страницу. И вторую позицию в листинге так же лучше занимать не мордой, а ещё одной внутренней страницей.

Вот собственно и всё моё занудство на сегодня. С нетерпением жду завтрашнего урока от Стомпернета.